O custo real da qualidade dos dados reativos

Gartner® estima isso “Até 2026, 50% das empresas que implementam arquiteturas de dados distribuídas terão adotado ferramentas de observabilidade de dados para melhorar a visibilidade do estado do cenário de dados, acima de menos de 20% em 2024”. Mas a observabilidade dos dados vai além do monitoramento – é um facilitador estratégico para a criação de confiança nos dados, enquanto controla os custos crescentes de qualidade de dados em toda a empresa.

A pilha de dados corporativos de hoje é uma colcha de retalhos de tecnologias antigas e novas – complexa, fragmentada e difícil de gerenciar. À medida que os dados fluem da ingestão ao armazenamento, transformação e consumo, o risco de falha se multiplica. Os métodos tradicionais não podem mais acompanhar.

- As equipes de dados perdem até 40% de seu tempo lutando contra incêndios, em vez de se concentrar no valor estratégico.

- Os gastos em nuvem continuam a aumentar, impulsionados por abordagens ineficientes e reativas à qualidade dos dados.

- Os investimentos da IA ficam aquém quando os modelos são construídos com dados não confiáveis ou incompletos.

- Os riscos de conformidade crescem à medida que as organizações não têm a visibilidade necessária para rastrear e confiar em seus dados.

As abordagens de qualidade de dados de hoje estão presas no passado:

1. O problema do legado

Os métodos tradicionais de qualidade de dados levaram a uma tempestade perfeita de ineficiência e pontos cegos. À medida que os volumes de dados escalam, as organizações lutam contra a criação manual de regras, forçando os engenheiros a construir e manter milhares de verificações de qualidade em sistemas fragmentados. O resultado? Um processo de trabalho intensivo que se baseia na amostragem seletiva, deixando problemas críticos de qualidade de dados não detectados. Ao mesmo tempo, o monitoramento permanece focado nas métricas de infraestrutura – como a CPU e a memória – em vez da integridade dos próprios dados.

O resultado é a visibilidade fragmentada, onde os problemas em um sistema não podem ser conectados a problemas em outros lugares – tornando quase impossível a análise de causa raiz. As equipes de dados estão presas em um loop reativo, perseguindo falhas a jusante em vez de impedi -las na fonte. Esse combate constante de incêndio corroe a produtividade e, mais criticamente, a confiança nos dados que sustentam as principais decisões de negócios.

- Os cheques manuais e baseados em regras não escalam-deixando a maioria dos conjuntos de dados não monitorados.

- A amostragem para cortar custos introduz pontos cegos que colocam decisões críticas em risco.

- O monitoramento da infraestrutura ignora o que mais importa: os dados em si.

- As ferramentas de monitoramento desconectadas impedem que as equipes vejam a imagem completa nos pipelines.

2. O dreno orçamentário oculto

A mudança para a infraestrutura de dados em nuvem foi destinada a otimizar os custos – mas as abordagens tradicionais de observabilidade entregaram o oposto. À medida que as equipes expandem o monitoramento em sua pilha de dados, as consultas intensivas em computação impulsionam picos de custo imprevisíveis nos sistemas de produção. Com transparência de custo limitado, é quase impossível rastrear despesas ou planejar orçamentos de maneira eficaz. Como escalas de dados, o mesmo acontece com os custos – rápido. As empresas enfrentam uma escolha difícil: reduzir o monitoramento e arriscar questões não detectadas, ou manter a cobertura e justificar o aumento dos gastos em nuvem para financiar os líderes. Essa imprevisibilidade de custo agora é uma barreira-chave para a adoção da observabilidade de dados de grau de empresa.

- O processamento ineficiente gera custos excessivos de computação e armazenamento.

- A transparência de custo limitada torna a otimização e o orçamento um desafio.

- O aumento dos volumes de dados amplia os custos, tornando a escalabilidade uma preocupação crescente.

3. O gargalo da arquitetura

A maioria das soluções de observabilidade de dados cria algemas arquitetônicas que limitam severamente a flexibilidade e escalabilidade técnica de uma organização. Essas soluções são normalmente projetadas como componentes fortemente integrados que ficam profundamente incorporados em plataformas ou tecnologias de dados específicas, forçando as organizações a compromissos de fornecedores de longo prazo e limitando as opções futuras de inovação.

Quando as verificações de qualidade são executadas diretamente nos sistemas de produção, eles competem por recursos críticos com as operações comerciais principais, geralmente causando degradação significativa do desempenho durante os períodos de pico – precisamente quando a confiabilidade é mais importante. As limitações arquitetônicas forçam as equipes de dados a desenvolver soluções alternativas complexas de engenharia para manter o desempenho, criando dívidas técnicas e consumindo valiosos recursos de engenharia.

- Soluções bem acopladas que o travam em plataformas específicas.

- Degradação do desempenho ao executar verificações nos sistemas de produção.

- Utilização de recursos ineficientes que exigem engenharia personalizada.

O ACIAN traz uma nova abordagem para a confiabilidade dos dados

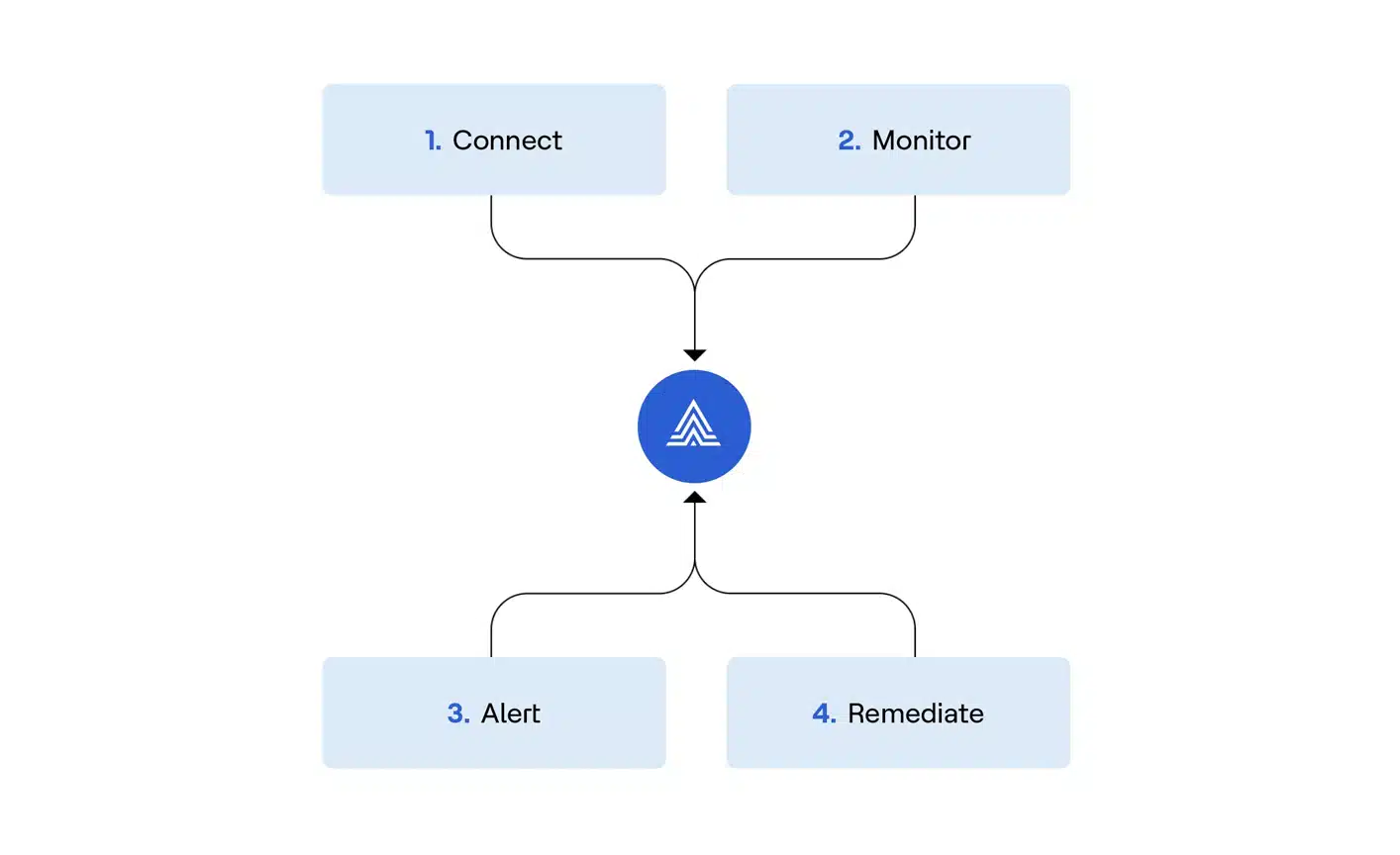

A observabilidade dos dados do ACIAN representa uma mudança fundamental do combate reativo de incêndio para a confiabilidade proativa de dados. Aqui está como somos diferentes:

1. Proativo, não reativo

Maneira tradicional: Descobrir problemas de qualidade de dados após o impacto de decisões de negócios.

Caminho ACIANO: Detecção de anomalia movida a IA que captura questões no início do pipeline usando idéias orientadas por ML.

2. Economia em nuvem previsível

Maneira tradicional: Bills de nuvem imprevisíveis que surgem com o volume de dados.

Caminho ACIANO: Garantia sem custos com arquitetura eficiente que otimiza o consumo de recursos.

3. Cobertura completa, sem amostragem

Maneira tradicional: Amostragem de dados para economizar custos, criando pontos cegos críticos.

Caminho ACIANO: Cobertura de dados 100% sem compromisso através do processamento inteligente.

4. Liberdade arquitetônica

Maneira tradicional: Bloqueio de fornecedor com opções de integração limitadas.

Caminho ACIANO: Arquitetura aberta com suporte nativo do Apache Iceberg e integração perfeita em pilhas de dados modernas.

Impacto no mundo real

Caso de uso 1: eficiência do pipeline de dados com “Shift-Left”

Transforme suas operações de dados capturando problemas na fonte:

- Implementar verificações abrangentes de DQ em estágios de ingestão, transformação e fonte.

- Integrar -se aos fluxos de trabalho do CI/CD para pipelines de dados.

- Reduza os custos de retrabalho e acelere o tempo de valor.

Caso de uso 2: Monitoramento do ciclo de vida Genai

Verifique se suas iniciativas de IA oferecem valor comercial:

- Valide a qualidade dos dados de treinamento e fontes de conhecimento de trapos.

- Monitore alucinações, preconceitos e desvio de desempenho.

- Rastrear métricas operacionais do modelo em tempo real.

Caso de uso 3: análise de autoatendimento seguro

Capacite sua organização com exploração de dados confiante:

- Incorporar indicadores de saúde em tempo real em catálogos e ferramentas de BI.

- Monitore os padrões de uso do conjunto de dados proativamente.

- Construir confiança através da transparência e validação.

A vantagem do ACIANO: Cinco diferenciadores que importam

- Sem amostragem de dados: Cobertura de dados 100% para observabilidade abrangente.

- Nenhuma garantia de aumento de custo da nuvem: Economia previsível em escala.

- Arquitetura de cópia zero segura: Acesse metadados sem cópias de dados caros.

- Cargas de trabalho de IA escaláveis: Recursos de ML projetados para escala corporativa.

- Suporte nativo do Apache Iceberg: Observabilidade incomparável para formatos de tabela modernos.

Comece

Faça um passeio de produto E entender melhor como transformar suas operações de dados do caos reativo em controle proativo.

Luis es un experto en Inteligência Empresarial, Redes de Computadores, Gestão de Dados e Desenvolvimento de Software. Con amplia experiencia en tecnología, su objetivo es compartir conocimientos prácticos para ayudar a los lectores a entender y aprovechar estas áreas digitales clave.